深度信念网络(Deep Belief Network)

发布时间:2016-02-18 栏目:深度学习 评论:0 Comments

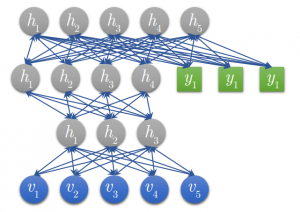

DBN 是由多层 RBM 组成的一个神经网络,它既可以被看作一个生成模型,也可以当作判别模型,其训练过程是:使用非监督贪婪逐层方法去预训练获得权值。

训练过程:

1. 首先充分训练第一个 RBM;

2. 固定第一个 RBM 的权重和偏移量,然后使用其隐性神经元的状态,作为第二个 RBM 的输入向量;

3. 充分训练第二个 RBM 后,将第二个 RBM 堆叠在第一个 RBM 的上方;

4. 重复以上三个步骤任意多次;

5. 如果训练集中的数据有标签,那么在顶层的 RBM 训练时,这个 RBM 的显层中除了显性神经元,还需要有代表分类标签的神经元,一起进行训练:

a) 假设顶层 RBM 的显层有 500 个显性神经元,训练数据的分类一共分成了 10 类;

b) 那么顶层 RBM 的显层有 510 个显性神经元,对每一训练训练数据,相应的标签神经元被打开设为 1,而其他的则被关闭设为 0。

6. DBN 被训练好后如下图: (示意)

另:

调优过程 (Fine-Tuning) :

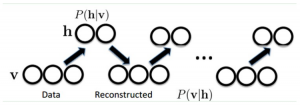

生成模型使用 Contrastive Wake-Sleep 算法进行调优,其算法过程是:

1. 除了顶层 RBM,其他层 RBM 的权重被分成向上的认知权重和向下的生成权重;

2. Wake 阶段:认知过程,通过外界的特征和向上的权重 (认知权重) 产生每一层的抽象表示 (结点状态) ,并且使用梯度下降修改层间的下行权重 (生成权重) 。也就是“如果现实跟我想象的不一样,改变我的权重使得我想

象的东西就是这样的”。

3. Sleep 阶段:生成过程,通过顶层表示 (醒时学得的概念) 和向下权重,生成底层的状态,同时修改层间向上的权重。也就是“如果梦中的景象不是我脑中的相应概念,改变我的认知权重使得这种景象在我看来就是这个概

念”。

使用过程 :

1. 使用随机隐性神经元状态值,在顶层 RBM 中进行足够多次的吉布斯抽样;

2. 向下传播,得到每层的状态。

留下评论

You must be logged in to post a comment.

近期评论

- Pika发表在《莫里斯蠕虫(Morris Worm)》

- Pika发表在《多组学科研分析》

- crisy发表在《最近关于专利的一点感想》

- walter发表在《机器学习基础知识回顾-马尔科夫过程(Markov Process)》

文章归档

- 2024年3月

- 2024年2月

- 2023年12月

- 2023年11月

- 2023年10月

- 2023年9月

- 2023年8月

- 2023年7月

- 2023年6月

- 2023年5月

- 2023年4月

- 2023年3月

- 2023年2月

- 2023年1月

- 2022年12月

- 2022年11月

- 2022年9月

- 2022年8月

- 2022年7月

- 2022年6月

- 2022年5月

- 2022年3月

- 2022年2月

- 2022年1月

- 2021年12月

- 2021年11月

- 2021年10月

- 2021年9月

- 2021年8月

- 2021年7月

- 2021年6月

- 2021年5月

- 2021年4月

- 2021年2月

- 2021年1月

- 2020年12月

- 2020年11月

- 2020年10月

- 2020年8月

- 2020年7月

- 2020年6月

- 2020年5月

- 2020年4月

- 2020年3月

- 2020年2月

- 2019年7月

- 2019年5月

- 2019年3月

- 2019年1月

- 2018年6月

- 2018年5月

- 2018年4月

- 2018年3月

- 2018年2月

- 2017年11月

- 2017年7月

- 2017年6月

- 2017年5月

- 2017年3月

- 2016年12月

- 2016年11月

- 2016年10月

- 2016年9月

- 2016年8月

- 2016年7月

- 2016年6月

- 2016年5月

- 2016年4月

- 2016年3月

- 2016年2月

- 2016年1月

- 2015年12月

- 2015年11月