【转】超限学习机(Extreme Learning Machine)

发布时间:2016-10-07 栏目:人工智能, 机器学习, 深度学习 评论:0 Comments

1. ELM 是什么

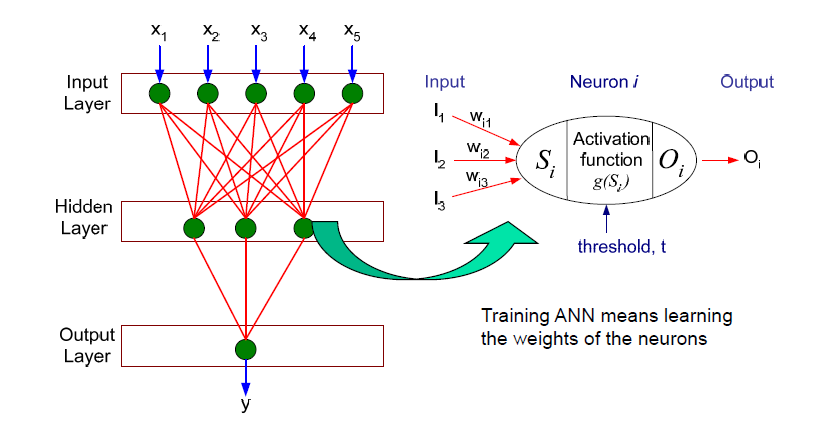

ELM的个人理解: 单隐层的前馈人工神经网络,特别之处在于训练权值的算法: 在单隐层的前馈神经网络中,输入层到隐藏层的权值根据某种分布随机赋予,当我们有了输入层到隐藏层的权值之后,可以根据最小二乘法得到隐藏层到输出层的权值,这也就是ELM的训练模型过程。

与BP算法不同,BP算法(后向传播算法),输入层到隐藏层的权值,和隐藏层到输出层的权值全部需要迭代求解(梯度下降法)

用一张老图来说明,也就是说上图中的Wi1,Wi2,Wi3 在超限学习机中,是随机的,固定的,不需要迭代求解的。我们的目标只需要求解从隐藏层到输出层的权值。毫无疑问,相对于BP算法,训练速度大大提高了。

2. ELM 的训练过程

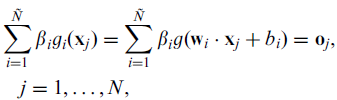

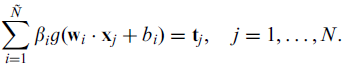

在上述公式中,wi 表示输入层到隐藏层的权值, bi表示系统偏置(bias),ß 则是我们的目标:隐藏层到输出层的权值,N 表示训练集的大小,oj 表示分类结果。为了无限逼近训练数据的真实结果,我们希望分类结果与真实结果t一致,那么也就是 所以上式可以表示为

所以上式可以表示为 (懒了,不想用公式编辑器,TAT)

(懒了,不想用公式编辑器,TAT)

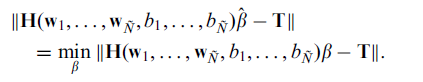

用矩阵表示,则

其中N 表示训练集的大小,N~ 表示隐藏层结点的数量,g(x)表示active function(激活函数?),g(x)要求无限可微。

怎么求解这个方程就成为了ELM的训练过程,恩。

求解方法:1. 传统的梯度下降法 (不说了,就是BP算法)

2. LS 最小二乘法方法

目标:最小化误差

根据 Hß = T, 如果H 是一个方阵的话,ß可以直接求解为H-1T。

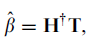

如果H不是, 最小误差的ß 为  ,其中H+ 为H的Moore-Penrose 广义逆。

,其中H+ 为H的Moore-Penrose 广义逆。

留下评论

You must be logged in to post a comment.

近期评论

- Pika发表在《莫里斯蠕虫(Morris Worm)》

- Pika发表在《多组学科研分析》

- crisy发表在《最近关于专利的一点感想》

- walter发表在《机器学习基础知识回顾-马尔科夫过程(Markov Process)》

文章归档

- 2024年3月

- 2024年2月

- 2023年12月

- 2023年11月

- 2023年10月

- 2023年9月

- 2023年8月

- 2023年7月

- 2023年6月

- 2023年5月

- 2023年4月

- 2023年3月

- 2023年2月

- 2023年1月

- 2022年12月

- 2022年11月

- 2022年9月

- 2022年8月

- 2022年7月

- 2022年6月

- 2022年5月

- 2022年3月

- 2022年2月

- 2022年1月

- 2021年12月

- 2021年11月

- 2021年10月

- 2021年9月

- 2021年8月

- 2021年7月

- 2021年6月

- 2021年5月

- 2021年4月

- 2021年2月

- 2021年1月

- 2020年12月

- 2020年11月

- 2020年10月

- 2020年8月

- 2020年7月

- 2020年6月

- 2020年5月

- 2020年4月

- 2020年3月

- 2020年2月

- 2019年7月

- 2019年5月

- 2019年3月

- 2019年1月

- 2018年6月

- 2018年5月

- 2018年4月

- 2018年3月

- 2018年2月

- 2017年11月

- 2017年7月

- 2017年6月

- 2017年5月

- 2017年3月

- 2016年12月

- 2016年11月

- 2016年10月

- 2016年9月

- 2016年8月

- 2016年7月

- 2016年6月

- 2016年5月

- 2016年4月

- 2016年3月

- 2016年2月

- 2016年1月

- 2015年12月

- 2015年11月