SqueezeNet

发布时间:2020-11-23 栏目:人工智能, 图像处理, 深度学习 评论:0 Comments

SqueezeNet 发表于ICLR-2017,作者分别来自Berkeley和Stanford,SqueezeNet不是模型压缩技术,而是 “design strategies for CNN architectures with few parameters”

SqueezeNet的模型压缩使用了3个策略:

- 将

卷积替换成

卷积:通过这一步,一个卷积操作的参数数量减少了9倍;

- 减少

卷积的通道数:一个

卷积的计算量是

(其中

,

分别是输入Feature Map和输出Feature Map的通道数),作者任务这样一个计算量过于庞大,因此希望将

,

减小以减少参数数量;

- 将降采样后置:作者认为较大的Feature Map含有更多的信息,因此将降采样往分类层移动。注意这样的操作虽然会提升网络的精度,但是它有一个非常严重的缺点:即会增加网络的计算量。

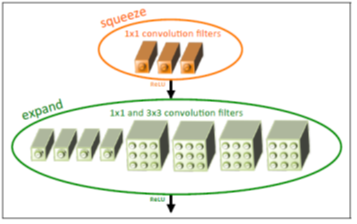

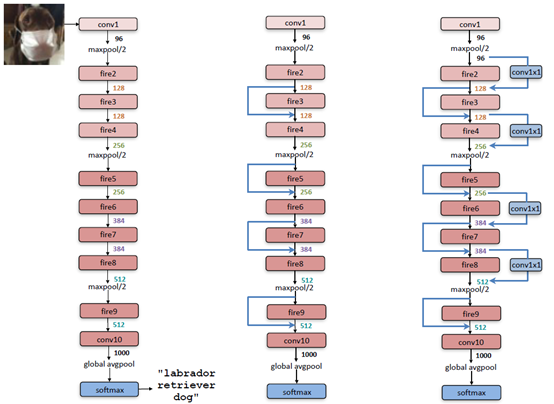

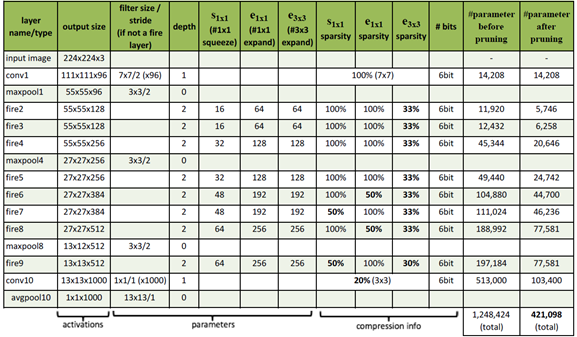

SqueezeNet的核心在于Fire module,Fire module 由两层构成,分别是squeeze层+expand层,如下图所示,squeeze层是一个1*1卷积核的卷积层,expand层是1*1 和3*3卷积核的卷积层,expand层中,把1*1 和3*3 得到的feature map 进行concat,具体操作如下图2所示

下面说一下SqueezeNet的一些具体的实现细节:

(1)在Fire模块中,expand层采用了混合卷积核1×1和3×3,其stride均为1,对于1×1卷积核,其输出feature map与原始一样大小,但是由于它要和3×3得到的feature map做concat,所以3×3卷积进行了padding=1的操作,实现的话就设置padding=”same”;

(2)Fire模块中所有卷积层的激活函数采用ReLU;

(3)Fire9层后采用了dropout,其中keep_prob=0.5;

(4)SqueezeNet没有全连接层,而是采用了全局的avgpool层,即pool size与输入feature map大小一致;

(5)训练采用线性递减的学习速率,初始学习速率为0.04。

参考:

https://zhuanlan.zhihu.com/p/49465950

https://blog.csdn.net/u011995719/article/details/78908755

https://zhuanlan.zhihu.com/p/31558773

Comments are closed.

近期评论

- Pika发表在《莫里斯蠕虫(Morris Worm)》

- Pika发表在《多组学科研分析》

- crisy发表在《最近关于专利的一点感想》

- walter发表在《机器学习基础知识回顾-马尔科夫过程(Markov Process)》

文章归档

- 2024年3月

- 2024年2月

- 2023年12月

- 2023年11月

- 2023年10月

- 2023年9月

- 2023年8月

- 2023年7月

- 2023年6月

- 2023年5月

- 2023年4月

- 2023年3月

- 2023年2月

- 2023年1月

- 2022年12月

- 2022年11月

- 2022年9月

- 2022年8月

- 2022年7月

- 2022年6月

- 2022年5月

- 2022年3月

- 2022年2月

- 2022年1月

- 2021年12月

- 2021年11月

- 2021年10月

- 2021年9月

- 2021年8月

- 2021年7月

- 2021年6月

- 2021年5月

- 2021年4月

- 2021年2月

- 2021年1月

- 2020年12月

- 2020年11月

- 2020年10月

- 2020年8月

- 2020年7月

- 2020年6月

- 2020年5月

- 2020年4月

- 2020年3月

- 2020年2月

- 2019年7月

- 2019年5月

- 2019年3月

- 2019年1月

- 2018年6月

- 2018年5月

- 2018年4月

- 2018年3月

- 2018年2月

- 2017年11月

- 2017年7月

- 2017年6月

- 2017年5月

- 2017年3月

- 2016年12月

- 2016年11月

- 2016年10月

- 2016年9月

- 2016年8月

- 2016年7月

- 2016年6月

- 2016年5月

- 2016年4月

- 2016年3月

- 2016年2月

- 2016年1月

- 2015年12月

- 2015年11月